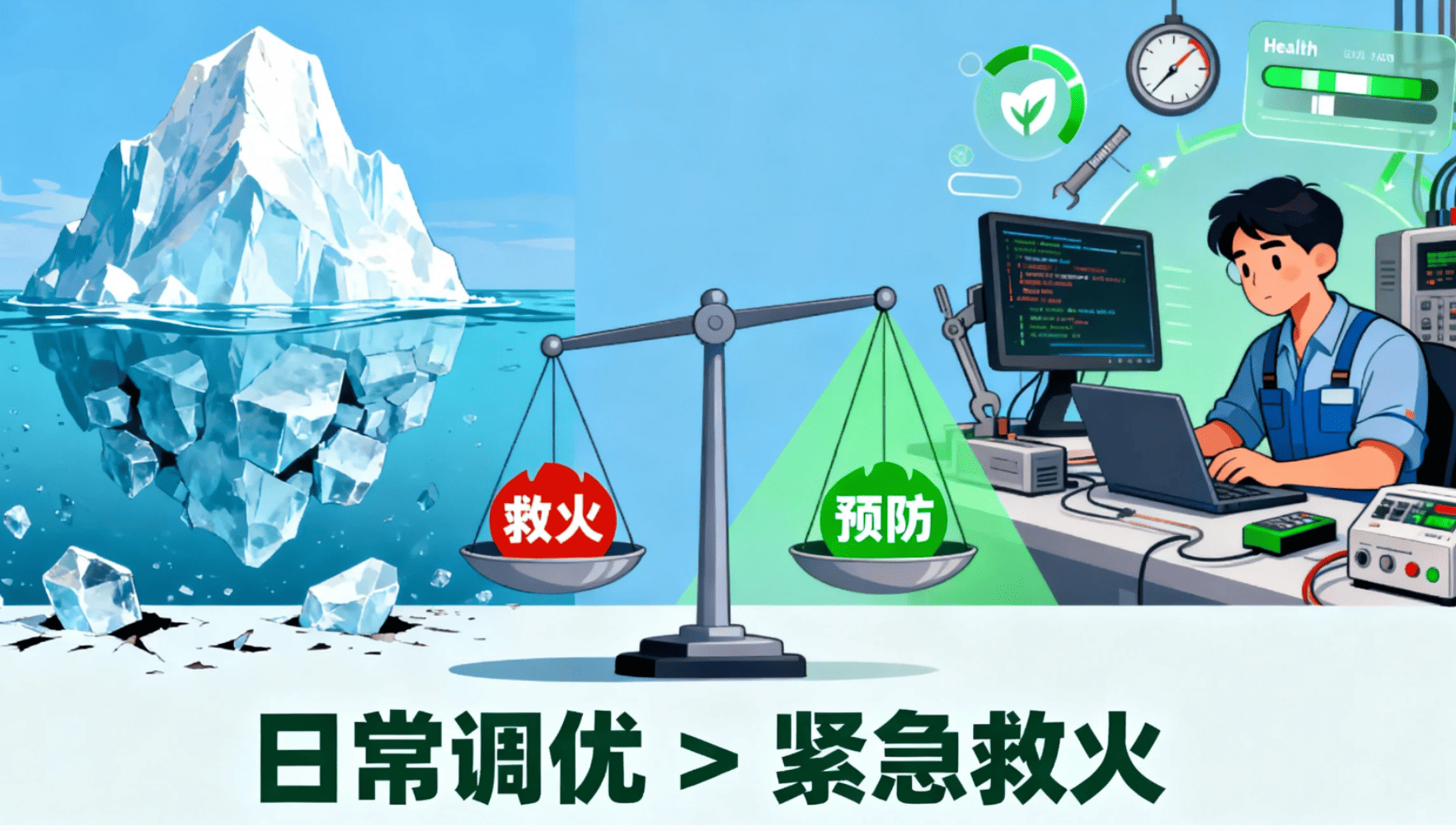

谁没被慢查询折磨过?报表加载持续转圈,ETL任务半夜超时失败,集群资源跑满却不知道瓶颈在哪……这些场景太熟悉了。性能调优不该是半夜被报警叫醒后靠“加节点、改SQL”硬扛的紧急灭火,而应像日常保养一样,融入数据仓库的整个生命周期——真正高效的数仓,从设计之初就考虑性能,并在迭代中持续优化。

本文不讲空泛理论,直接从工程师天天打交道的环节——建模设计、ETL流程、查询写法、资源管理——分享一套可落地、能复用的调优策略,帮你少踩坑,多交付。

一、建模:别让结构拖了后腿

l 很多性能问题,根源其实在建模阶段就埋下了。

l 星型模型优先:除非存储成本极其敏感,否则别为了“规范”搞雪花模型。多一层JOIN,查询就慢一分。星型模型扁平、直观、快,对分析场景更友好。

l 分层要清晰,别混用:ODS存原始数据,DWD做清洗和标准化,DWS预聚合指标,ADS面向应用侧。这样高频查询可以直接取DWS层,不用每次都从明细表重算。

l 警惕过度规范化:有些团队为了“减少冗余”,把维度拆得过细(比如城市、省份、国家拆成三张表),结果每次查个地区分布都要连五六张表。在分析场景中,适度冗余换查询效率,往往是更优解。

二、ETL:别让流水线变成堵车现场

l ETL是数仓的“心脏泵血”,一旦卡住,下游全瘫。

l 能增量,尽量不全量:每天重跑整张订单表?没必要。用时间戳、自增ID或CDC捕获变更,只处理新增/更新的数据。省下的不只是时间,还有钱。

l 任务拆小,并行跑:一个大任务跑4小时,不如拆成10个并行子任务,各跑20分钟。配合Airflow这类调度器,显式定义依赖,避免隐式串行。

l 中间结果该缓存就缓存:比如“近7日活跃用户”这种固定口径,与其每次查都聚合,不如每天凌晨算好存成一张DWS表。查询秒出,资源也省。

l 失败要有兜底:任务失败自动重试、断点续跑、告警通知——这些不是“高级功能”,是基本生存技能。

三、查询:SQL写得好,性能差不了

再强的底层架构,也扛不住一条低效SQL。

l 别写 SELECT *:只取你需要的字段。多传10列,网络和内存压力可能翻倍。

l 过滤条件尽量靠前:把 WHERE dt = '2025-11-21' 放在子查询最内层,让引擎尽早剪枝。这叫谓词下推(Predicate Pushdown),几乎所有现代引擎都支持。

l 别在字段上套函数:

错误示例:WHERE YEAR(event_time) = 2025 → 全表扫描

推荐写法:WHERE event_time >= '2025-01-01' AND event_time < '2026-01-01' → 走分区

l 学会看执行计划:多关注有没有全表扫描、数据倾斜、过多Stage——这些问题往往比“加资源”更容易解决。

四、资源管理:不只扩缩容,更要聪明用

性能和成本从来是一体两面,关键在于匹配负载节奏。

l 存算分离 ≠ 白天扩、夜间缩:

如果你的核心ETL都在凌晨跑(比如T+1批处理),那夜间才是计算高峰!正确的做法是:

○ 在任务开始前自动扩容计算资源(如拉高CU、增加Executor);

○ 任务结束后及时释放,避免空转计费。

云数仓(如Snowflake、MaxCompute、BigQuery)的弹性能力,正是为了应对这种可预测的波峰波谷。

l 善用 BI 工具的内置缓存:主流 BI 平台通常都支持对报表或数据集配置缓存策略。对于更新频率低但访问频繁的看板(比如每日经营日报),开启缓存并合理设置 TTL(如 1 小时),能显著降低数仓查询压力。

l 监控是调优的眼睛:建立慢查询TOP榜、任务耗时趋势、资源水位看板,才能把“感觉慢”变成“知道哪里慢”。

最后:调优是习惯,不是动作

性能问题很少是突然出现的,而是日积月累的结果。与其等系统崩了再救火,不如把调优变成日常:

l 新建表前,先想清楚分区键和存储格式;

l 写SQL时,顺手检查是否能下推过滤;

l 上线任务后,盯一眼资源消耗是否合理;

l 每周抽半小时,复盘几个慢任务,沉淀成团队规范。

好的数据仓库,不是跑得最快的那个,而是让你晚上能安心睡觉的那个。而这一切,始于你今天写的每一行代码、建的每一张表、调的每一个参数。